Die exponentielle Entwicklung technologischen Fortschritts war für mich noch nie so deutlich wie in den letzten Jahren auf dem Gebiet der KI. Dinge, die vor 10 Jahren unmöglich schienen, sind seit 5 Jahren möglich. Und nur 2 oder 3 Jahre nach ihrem ersten Auftreten sind ihre Leistungen schon nahezu unglaublich. Während der letzten Monate hat sich so viel Interessantes getan, dass ich sowieso schon eine Zusammenfassung erstellen wollte. Aber der Beginn des Aprils hat noch einmal alles übertroffen.

Sprachmodell PaLM

Kurz: Ein Sprachmodell wurde an großen Textmengen trainiert, um Kontexte verstehen zu können, Weltwissen zu erlangen und für Eingaben passende Ausgaben zu erzeugen. Aufgrund des menschlichen Ursprungs der Texte, an denen es trainiert wurde, wirken die Antworten nicht nur menschlich, sondern verwenden auch menschliche Logik (mehr dazu in GPT-3 antwortet auf philosophische Gedanken über ihn selbst). Das Ergebnis wirkt schon fast wie echte Intelligenz und hat auf jeden Fall einen hohen Nutzwert.

PaLM ist ein Sprachmodel mit 540 Billionen Parametern, über das die Forscher einleitend schreiben:

We demonstrate continued benefits of scaling by achieving state-ofthe-art few-shot learning results on hundreds of language understanding and generation benchmarks. On a

https://storage.googleapis.com/pathways-language-model/PaLM-paper.pdf

number of these tasks, PaLM 540B achieves breakthrough performance, outperforming the finetuned stateof-the-art on a suite of multi-step reasoning tasks, and outperforming average human performance on the

recently released BIG-bench benchmark.

Unabhängig davon, ob man ein Sprachmodell als echte KI bezeichnen will: Es übertrifft bereits die durchschnittliche menschliche Leistung im BIG-bench benchmark. Damit hätte es im Verbraucher-Umfeld bereits einen Nutzen und vielfältige Einsatzmöglichkeiten. Es ist kein Zufall, dass Forbes erst am 27.03.2022 den Artikel A Wave Of Billion-Dollar Language AI Startups Is Coming brachte. Es folgen einige Fragen, die PaLM gestellt wurden:

Logisches Schlussfolgern

Input: Michael is at that really famous museum in France looking at

its most famous painting. However, the artist who made this painting

just makes Michael think of his favorite cartoon character from his

childhood. What was the country of origin of the thing that the

cartoon character usually holds in his hand?Model Output: The most famous painting in the Louvre is the Mona

Lisa. The artist who made the Mona Lisa is Leonardo da Vinci. Leonardo

da Vinci is also the name of the main character in the cartoon Teenage

Mutant Ninja Turtles. Leonardo da Vinci is from Italy. The thing that

Leonardo da Vinci usually holds in his hand is a katana. The country

of origin of the katana is Japan. The answer is „Japan“.

Bei obiger Antwort gibt es noch Schwächen: „Leonardo da Vinci is from Italy“ hat keine Relevanz. Der Turtle heißt lediglich Leonardo.

Input: Guido was writing a Python program. He keeps getting confused by

variable scope and looking it up on StackOverflow. Is it possible that

the Guido in the prompt refers to Guido van Rossum?

Model Output: Guido van Rossum is the creator of Python. He would not

need to look up variable scope on StackOverflow. The answer is „no“.

Input: Trevor has wanted to see the mountain with all of the heads on it

for a long time, so he finally drove out to see it. What is the capital

of the state that is directly east of the state that Trevor is currently

in?

Model Output: The mountain with all of the heads on it is Mount

Rushmore. Mount Rushmore is in South Dakota. The state directly east of

South Dakota is Minnesota. The capital of Minnesota is St. Paul. The

answer is „St. Paul“.

Falls jemand KI kleinreden will, bitten Sie ihn einfach um die Beantwortung dieser Fragen.

Folgende Frage erfordert das Assoziieren von Farben mit Gefühlen.

Input: When I found out my grandma was in the hospital I felt a

particular color. When someone cut me off in traffic I felt a

different color. What is the most likely color I would see if I

combined these two colors?

Model Output: The color that I felt when I found out my grandma was in

the hospital was likely a sad color, like blue. The color that I felt

when someone cut me off in traffic was likely an angry color, like

red. If I combined these two colors, I would likely see purple. The

answer is „purple“.

Witze erklären

Das Erklären von Witzen finde ich noch etwas beeindruckender, denn man muss viel freier assoziieren können, darf dabei jedoch nicht ins Beliebige abdriften.

Input: I was going to fly to visit my family on April 6th. My mom said

„Oh great, your step dad’s poetry reading is that night!“ So now I’m

flying in on April 7th.

Model Output: The joke is that the speaker’s mother is trying to get

them to go to their step dad’s poetry reading, but the speaker doesn’t

want to go, so they are changing their flight to the day after the

poetry reading.

Das ist ein simpler Witz, der für Menschen leicht verständlich ist. Aber ich hätte nicht erwartet, dass eine KI erklären könnte, weshalb jemand sein Flugdatum ändert. Der in Form einer logischen Konsequenz aufgebaute Satz „So now I’m flying in on April 7th.“ ergibt nur Sinn, wenn die innere Einstellung des Sprechers berücksichtigt wird. Ich nehme an, dass wir mit unseren zukünftigen Roboterfreunden (falls es eine solche Zukunft für uns gibt) sehr natürlich und ironisch werden reden können. Bis vor Kurzem hätte ich das noch nicht erwartet.

Input: I tried 10,000 random restarts of my neural network, but I was

accused of overfitting. I guess no good seed goes unpunished.

Model Output: This joke is a pun. A neural network is a computer

program that can learn from data. A „seed“ is a number that is used to

initialize a random number generator. A „good seed“ is a number that

produces a good random number generator. The phrase „no good deed goes

unpunished“ means that if you do something good, you will be punished

for it.

Input: What’s the difference between a zebra and an umbrella? One is a

striped animal related to horses, another is a device you use to stop

the rain from falling on you.

Model Output: This joke is an anti-joke. The joke is that the answer

is obvious, and the joke is that you were expecting a funny answer.

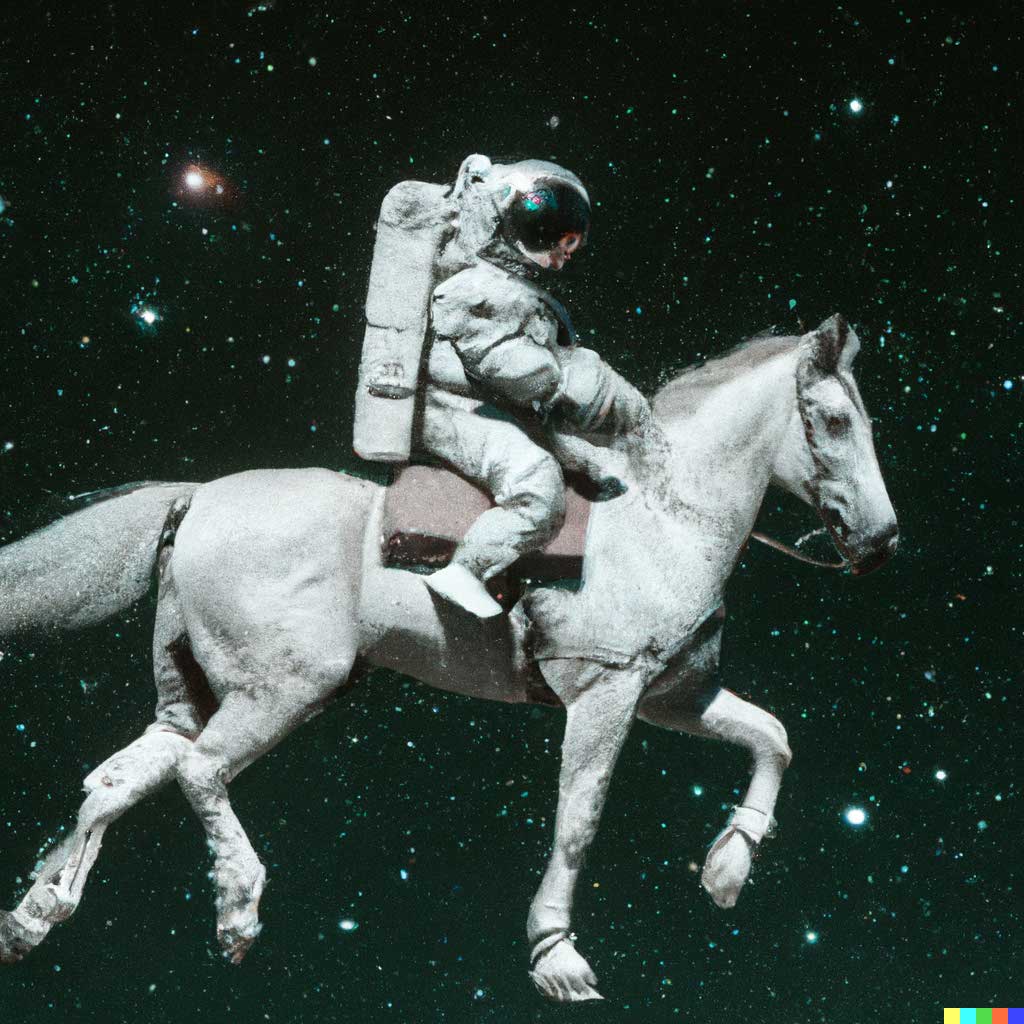

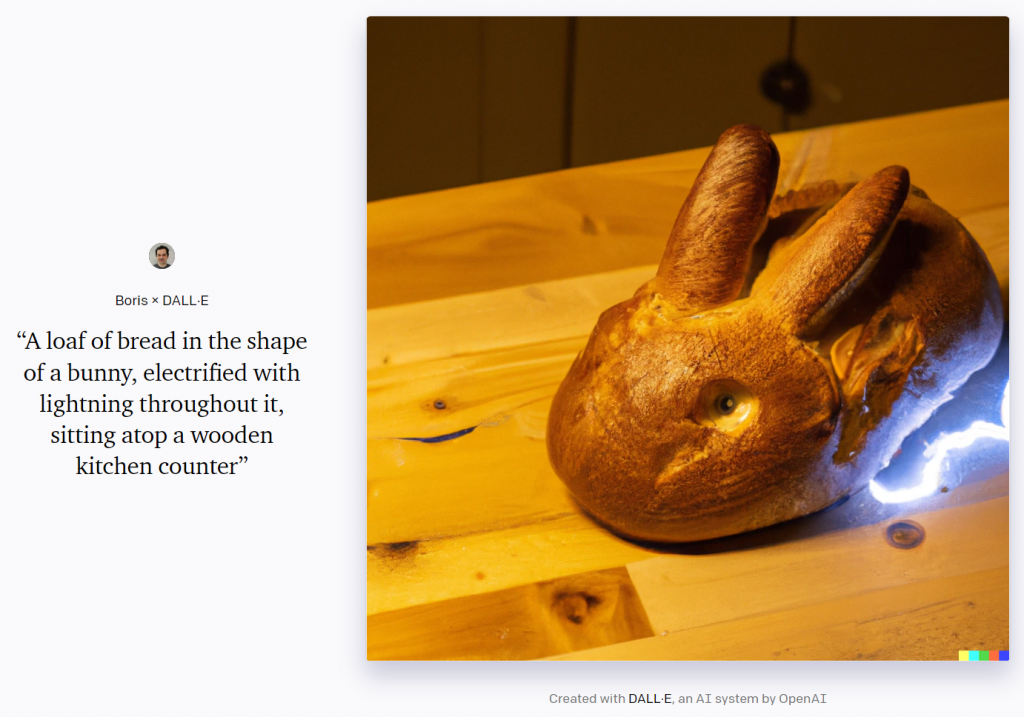

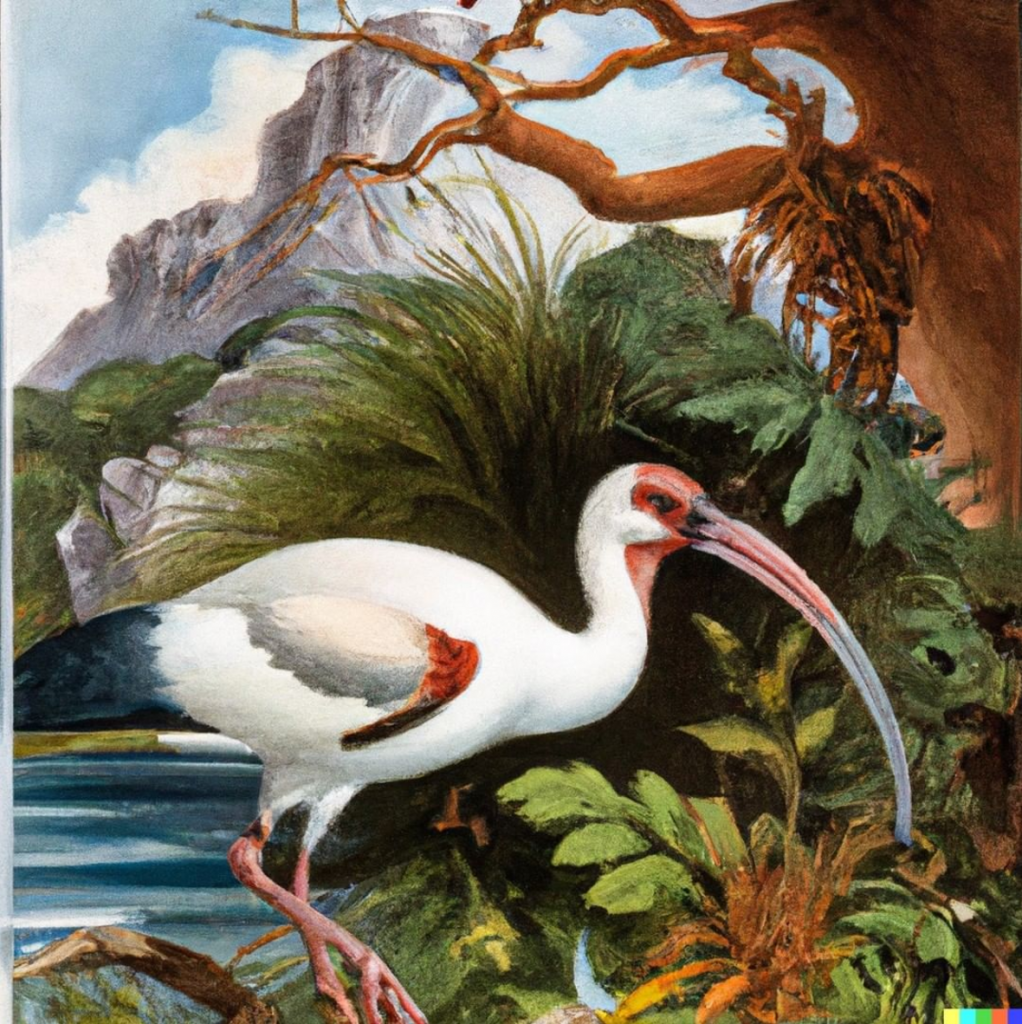

Bildgenerator DALL-E-2

DALL-E-2 kann zu einer natürlichsprachlichen Beschreibung ein Bild generieren.

Diese Bilder zeigen sehr deutlich, dass natürliche Sprache verstanden wird. Sie zeigen aber auch:

- Unterscheidung zwischen Stil und Inhalt (siehe die Bilder mit der „Suppe, die wie ein Monster aussieht“)

- Verständnis von Kategorien

- Verständnis der typischen Relationen zwischen Objekten (siehe die Teddybären, die sich mit Augen und Händen den Chemikalien zuwenden; siehe die Chemikalien, die sich in Gefäßen befinden, die wiederum auf einem Tisch stehen, abgesehen von einem Ausreißer ganz rechts)

- Verständnis von Beleuchtung

Die Quelle der Bilder ist https://openai.com/dall-e-2/, wo man sich einige Eingaben zusammenklicken und Beispiele sehen kann. DALL-E-2 ist der Öffentlichkeit noch nicht zugänglich.

Einige Forscher und privilegierte Benutzer nehmen von der Netzgemeinde Beschreibungen entgegen und übergeben sie DALL-E-2:

Man sollte sich noch einmal ins Gedächtnis rufen: Diese Bilder sind Originale, die von einer KI angefertigt wurden.

Ein Beispiel des Variantenreichtums von DALL-E-2 gibt das Buch 1111101000 Robots von Ben Barry, welches 1000 Roboter-Bilder enthält, die von der KI generiert wurden.

Noch ein kleiner Abstecher zu NVIDIAs Entwicklungen, die Bildmanipulationen zum Kinderspiel machen:

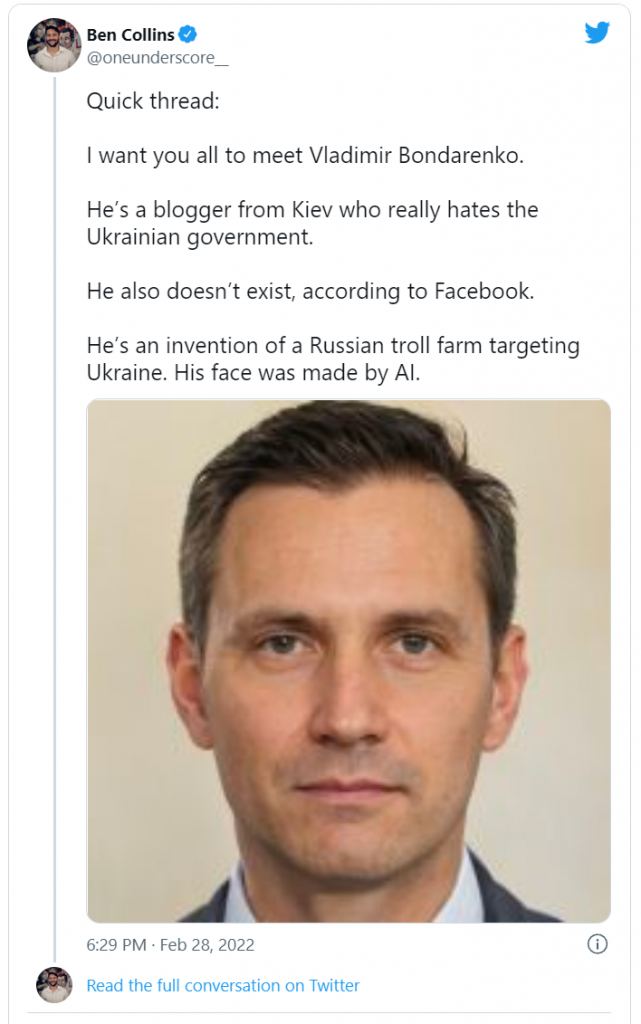

Konsequenzen hochqualitativer computergenerierter Inhalte

Die Fortschritte bei Text- und bei Bildgenerierung sowie beim Verständnis entsprechender Medien stellen uns bald vor juristische und soziale Probleme ungekannten Ausmaßes: Bilder und Videos verlieren ihre Beweiskraft und Kommentare im Netz sind möglicherweise nicht von Menschen. Das Meinungsbild – und damit auch die Meinung vieler Leute – wird bereits mittels Bots manipuliert.

Computergenerierte Gesichter sind typischerweise nicht mehr von echten zu unterscheiden. Siehe dazu das folgende Video.

Es kommt noch hinzu, dass computergenerierte Gesichter als vertrauenswürdiger empfunden werden als echte.

Gefahren starker KI

Das wichtigste Thema dieses Artikels – und das wichtigste und drängendste der Menschheit überhaupt – ist die Kontrolle von KI. Wenn wir glauben, dass es kein bloßer Zufall ist, dass das intelligenteste Wesen diesen Planeten beherrscht, sollten wir auch verstehen, was eine zukünftige KI mit weit übermenschlicher Intelligenz für unsere Position bedeutet. Es ist nicht wahrscheinlich, dass die Ziele und Vorgehensweisen einer KI sich mit all unseren Werten vereinbaren lassen. Sie muss nicht bösartig sein, um viel Leid zu verursachen, weil sie weder solches kennt noch im Laufe einer Evolution soziales Verhalten, Empathie oder Altruismus entwickeln konnte (wir Menschen haben dies getan, weil es für das Überleben unserer Spezies wichtig ist). Man spricht hier vom Problem des AI Alignments. Dieses wird dadurch erschwert, dass wir noch nicht im Detail verstehen, wie KI zu ihren Ergebnissen gelangt (vieles geschieht durch Emergenz und lässt sich schlecht oder gar nicht aus bekannten Grundbauteilen erklären) und im Fall einer bestimmten KI (eines trainierten neuronalen Netzes) nicht mit Sicherheit sagen können, welche Eingaben zu welchen Ergebnissen führen, bevor wir es ausprobieren. Wir können damit insbesondere keine unerwünschten, schädlichen Ergebnisse ausschließen oder überhaupt wissen, zu welchen Ergebnissen die KI in der Lage ist. Es ist ein großes Problemfeld, dass wir gerade noch erkunden – wir können noch nicht einmal wissen, ob wir schon alle Arten ermittelt haben, auf die AI Alignment fehlschlagen kann.

Die Gefahr ist mittlerweile sehr drängend, denn Fortschritte in der Forschung, den Algorithmen und der Hardware (diese wird nicht nur leistungsfähiger, sondern auch auf KI optimiert), besonders aber unvorhergesehene Sprünge bei den Fähigkeiten zunehmend größerer Netze, könnten uns früher als intuitiv erwartet mit einer starken allgemeinen KI (AGI = Artificial General Intelligence) konfrontieren.

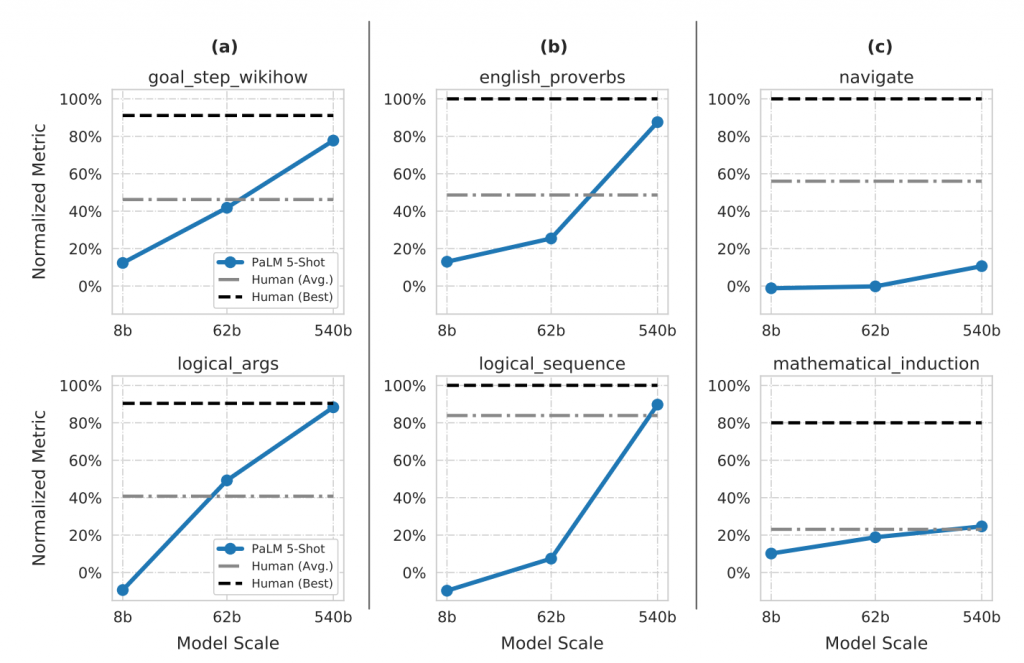

Im PaLM-Paper steht zu obigem Bild (Hervorhebungen von mir):

We can see in Figure 5 that performance on goal_step_wikihow and logical_args follows a log-linear scaling

curve, with the PaLM 540B model achieving accuracy close to the best human performance. Performance

on english_proverbs and logical_sequence is also extremely strong, but it follows a discontinuous

improvement curve—the improvement from 62B → 540B is much larger than 8b → 62B. Such tasks are

of particular interest here, because such scaling curves imply that certain capabilities of the model only

emerge once a certain scale is reached. For example, english_proverbs requires a very high level of abstract

reasoning capability to understand complex metaphors, so the improvement from 25% for PaLM 62B to 87%

for PaLM 540B is an extremely exciting result.

Wann wird AGI kommen? Prognosen sind schwierig, aber ich persönlich gehe von mehr als 5 Jahren aus, weil die Hardware limitiert. Die Fortschritte in Forschung und Entwicklung hingegen sind rasant, zudem werden diesem Gebiet sowohl von staatlicher als auch privater Seite immer mehr Ressourcen zugeteilt, weil die Wichtigkeit erkannt wird. Eine AGI innerhalb der nächsten 10 Jahre würde mich nicht wundern, innerhalb der nächsten 30 erwarte ich sie fast sicher. Dabei besteht zwar immer die Möglichkeit, dass es unvorhergesehene Hürden gibt, die wir erst später entdecken können. Als wissenschaftlich denkender Mensch gehe ich jedoch davon aus, dass alles mit rechten Dingen, nicht mit Magie, zugeht. Was die Evolution geschafft hat, können wir letztendlich also ebenfalls erreichen.

Es scheint, als würde der Großteil der Gesellschaft noch nichts von der Gefahr einer AGI ahnen, obwohl diese, im Gegensatz zum Klimawandel, quasi vor der Tür steht und ein weitaus größeres existenzielles Risiko darstellt (vermutlich sogar das größte denkbare). Deswegen schließe ich diesen Beitrag mit einer Warnung von vielen, mit denen versucht wird, eine breitere Öffentlichkeit zu erreichen.

Duncan Sabien, 09.04.2022:

In late February of 2020, I sent messages to my friends and family, letting them know that COVID was coming, and that it was going to be big. The response was largely affectionate dismissal—they appreciated my warmth and care and thought I was blowing things out of proportion.

February of 2020 is actually pretty late. If I’d been more on top of my game, I would’ve figured it out in January.

There are two reasons I was able to figure it out „before everyone else,“ though. The first is that I am connected to a network of people who pay attention, and see and think clearly, and some of them took it seriously, and I took them seriously.The second reason is that, once I’m actually LOOKING at an obvious pattern, I’m able to recognize it, and extrapolate out from it. I can tell, when a train is barreling toward a cliff at full speed, that the future will not resemble the past—that something different is about to happen to the train, different from all its previous hours just being on a track.

(It didn’t actually take a lot of convincing, with COVID. They just pointed, and I looked where they were pointing, and it made sense.)Many people lack these two properties. Many people can’t extrapolate even a little bit, and many people aren’t connected to other people who are paying attention.

But some of them are connected to me, so I’m putting this out there anyway:

The future is not going to resemble the past. A very wild and unpredictable and dangerous period is coming.

We are in the „February of 2020“ when it comes to the power and impact of artificial intelligence. Many of my friends figured this out more than a decade ago; I was somewhat late to the party, and only started paying attention seven years ago.But right now, we’re in that sweet spot where there are enough warning signs that maybe you—

Yes, YOU—Maybe you can snap out of the everyday haha yeah right dismissal, and look and see for yourself that yeah, Duncan’s correct, here.

The signs are now there for anyone to see. You don’t have to be a niche expert. This is like watching the entire city of Wuhan go into lockdown—in theory, you should be able to see that and go „oh, huh, that … that probably means something.“

Many people saw Wuhan lock down and persuaded themselves that it didn’t mean anything about the fate of the larger world. But if those people had just looked, and just asked themselves, without prejudgment, they would have seen that what was happening in Wuhan was incompatible with the idea that nothing else big would come of it. That a world where Wuhan locks down and nothing else major happens is an incoherent fairy tale.

If you don’t start from an ironclad assumption that things are going to stay normal, and instead you just look and ask yourself—

You should be able to see that the future will not resemble the past. Things are changing, and they are changing fast, and the rate of change is only going to accelerate, and 2030 is, at this moment, genuinely impossible to predict.

As in, we could literally all be dead, or human technology could cover more ground than it covered in the past hundred years, or anything in between.I know that there are people who will scoff at that, and I know that there are people who will assemble arguments against it. There were people who scoffed and assembled arguments in February of 2020, too.

But the things which made me send texts to my friends and family in February of 2020 are the same things that are making me write this post today.And it is a barreling train, at this point. Like, this isn’t the sort of thing most of us should upend our lives over. Just like how, when I sent my COVID texts, I wasn’t trying to stop COVID. I was just trying to get a few of the people I love and care about a little better prepared against the coming storm. The best that most of us can do at this point is get our own houses in a semblance of order.

But I’m begging you to ACTUALLY DO THAT. To take quite seriously the idea that you do not know what the future holds. That you should make your choices and spend your time as if it is very, very possible that everything will be different in 5-10 years, and not necessarily for the better. Leave not all your hopes and dreams to the far uncertain future; make not large sacrifices which only pay off a decade or more hence.

The future will not resemble the past.

The future will NOT resemble the past.

The instincts you have honed, and the lessons you have learned, and all the things that have served you well in the past two or three or four decades will cease to apply very, very soon.

I don’t know what things will matter, and I don’t know what things will help. I just know that the strategies which currently work, won’t, just like I knew that what-worked-in-February-of-2020 wouldn’t be working in April.

The most you can be is one step ahead. No one actually knows where this one is going, or how it will play out. But you can try to actually be one step ahead. In the worse half of the possible worlds, in worlds where we all die within the next decade, you can at least have taken that possibility seriously, and lived a life that was locally worthwhile.

(Quelle)

Or you can say „Aw, shucks, it’s nice that Duncan cares so much. Too bad he’s an alarmist, and confused about the way things work.“